Un edificio grigio rettangolare alla periferia di San Jose ospita file su file di macchine lampeggianti. Grovigli di cavi colorati collegano server di fascia alta, dispositivi di rete e sistemi di archiviazione dati. Unità di aria condizionata ingombranti ronzano sopra la testa. Il rumore costringe i visitatori a urlare.

L’edificio appartiene a Equinix, un’azienda che affitta spazio per data center. L’attrezzatura al suo interno appartiene a aziende, dalle grandi corporazioni alle startup, che la utilizzano sempre di più per far funzionare i loro sistemi di intelligenza artificiale (IA). La corsa all’oro dell’IA, stimolata dalla sorprendente sofisticazione dei sistemi “generativi” come ChatGPT, un’apprezzato conversazionalista virtuale, promette di generare ricchi profitti per coloro che sfruttano il potenziale della tecnologia. Come nei primi giorni di qualsiasi corsa all’oro, però, sta già creando fortuna per i venditori delle attrezzature necessarie.

Il 24 maggio Nvidia, che progetta i semiconduttori preferiti da molti server di IA, ha superato le previsioni di ricavi e utili degli analisti per i tre mesi fino ad aprile. Si aspetta vendite di 11 miliardi di dollari nel trimestre in corso, la metà in più rispetto alle previsioni di Wall Street. Mentre il suo prezzo delle azioni è salito del 30% il giorno successivo, il valore di mercato dell’azienda si è avvicinato al trilione di dollari. Il CEO di Nvidia, Jensen Huang, ha dichiarato il 29 maggio che il mondo si trova “al punto di svolta di una nuova era informatica”.

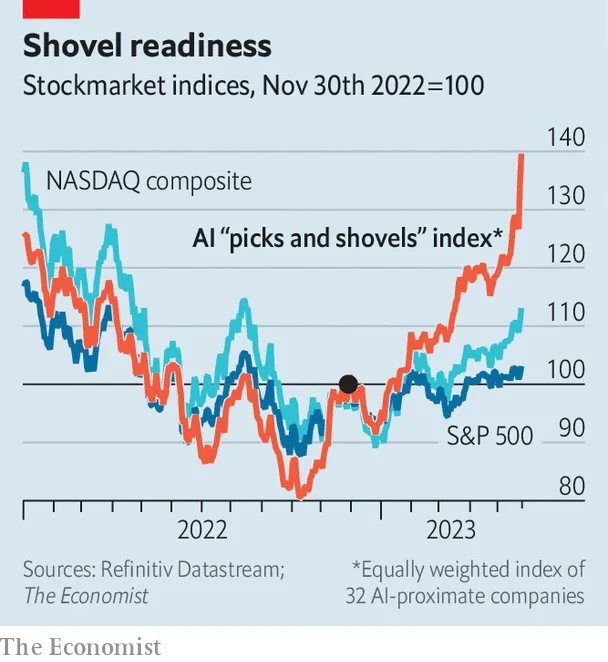

Altre aziende di chip, dagli altri progettisti come AMD ai produttori come TSMC di Taiwan, sono state coinvolte nell’entusiasmo dell’IA. Lo stesso vale per i fornitori di altre infrastrutture informatiche, che includono tutto, dalle quei cavi colorati, alle unità di aria condizionata rumorose e allo spazio del data center, fino al software che aiuta ad eseguire i modelli di intelligenza artificiale (IA) e a gestire i dati. Un indice equamente ponderato di una trentina di tali aziende è aumentato del 40% dal lancio di ChatGPT a novembre, rispetto al 13% dell’indice tecnologico NASDAQ (vedi grafico). “Sta emergendo una nuova pila tecnologica”, riassume Daniel Jeffries dell’AI Infrastructure Alliance, un gruppo di lobby.

A prima vista, gli elementi dell’IA sembrano molto meno entusiasmanti rispetto ai “grandi modelli di linguaggio” intelligenti dietro ChatGPT e alla sua vasta gamma di concorrenti. Ma mentre i costruttori di modelli e i produttori di applicazioni che si appoggiano su quei modelli cercano una fetta della futura torta dell’IA, tutti hanno bisogno di potenza di calcolo qui e ora, e molta.

I sistemi di IA più recenti, inclusi quelli generativi, richiedono molta più potenza di calcolo rispetto ai sistemi più vecchi, figuriamoci rispetto alle applicazioni non-IA. Amin Vahdat, responsabile dell’infrastruttura di intelligenza artificiale presso Google Cloud Platform, il braccio di cloud computing del gigante di internet, osserva che le dimensioni dei modelli sono aumentate di dieci volte ogni anno negli ultimi sei anni. GPT-4, l’ultima versione di quello che alimenta ChatGPT, analizza i dati utilizzando forse 1 trilione di parametri, più del cinque volte rispetto al suo predecessore. Man mano che i modelli diventano più complessi, le esigenze computazionali per addestrarli aumentano di conseguenza.

Una volta addestrati, gli IA richiedono una capacità di calcolo inferiore per essere utilizzati in un processo chiamato inferenza. Tuttavia, date le diverse applicazioni disponibili, l’inferenza richiederà anche, in modo cumulativo, molta potenza di elaborazione. Microsoft ha più di 2.500 clienti per un servizio che utilizza la tecnologia di OpenAI, il creatore di ChatGPT, di cui il gigante del software possiede quasi la metà. Ciò rappresenta un aumento di dieci volte rispetto al trimestre precedente. La casa madre di Google, Alphabet, ha sei prodotti con più di 2 miliardi di utenti in tutto il mondo – e ha pianificato di potenziarli con l’IA generativa.

I vincitori più evidenti dalla crescente domanda di potenza di calcolo sono i produttori di chip. Aziende come Nvidia e AMD ottengono una royalty ogni volta che le loro progettazioni vengono incise su silicio da parte di produttori come TSMC per conto dei clienti finali, in particolare i grandi fornitori di cloud computing che alimentano la maggior parte delle applicazioni di intelligenza artificiale. L’IA è quindi un vantaggio per i progettisti di chip, poiché trae beneficio da chip più potenti (che tendono a generare margini più alti) e da un maggior numero di chip. UBS, una banca, stima che nei prossimi uno o due anni l’IA aumenterà la domanda di chip specialistici noti come unità di elaborazione grafica (GPU) di 10-15 miliardi di dollari.

Di conseguenza, il fatturato annuale dei data center di Nvidia, che rappresenta il 56% delle sue vendite, potrebbe raddoppiare. AMD lancerà una nuova GPU entro la fine dell’anno. Sebbene sia un giocatore molto più piccolo nel campo della progettazione di GPU rispetto a Nvidia, l’entità del boom dell’IA significa che l’azienda è pronta a beneficiarne, “anche se ottenesse solo le briciole” del mercato, secondo Stacy Rasgon di Bernstein, una società di brokeraggio. Startup di progettazione di chip focalizzate sull’IA, come Cerebras e Graphcore, stanno cercando di farsi un nome. PitchBook, un fornitore di dati, conta circa 300 di tali aziende.

Naturalmente, parte dei profitti andrà anche ai produttori. A aprile, il CEO di TSMC, C.C. Wei, ha parlato cautamente di un “incremento incrementale nella domanda legata all’IA”. Gli investitori sono stati piuttosto entusiasti. Il prezzo delle azioni della società è aumentato del 10% dopo gli ultimi risultati di Nvidia, aggiungendo circa 20 miliardi di dollari alla sua capitalizzazione di mercato. Beneficiari meno evidenti includono anche le aziende che consentono di confezionare più chip in un’unica unità di elaborazione. Besi, un’azienda olandese, produce gli strumenti che aiutano a collegare i chip. Secondo Pierre Ferragu di New Street Research, un’altra società di analisti, l’azienda olandese controlla tre quarti del mercato per il bonding ad alta precisione. Il suo prezzo delle azioni è aumentato di oltre la metà quest’anno.

UBS stima che le GPU rappresentino circa la metà del costo dei server AI specializzati, rispetto al decimo dei server standard. Ma non sono l’unico equipaggiamento necessario. Per funzionare come un singolo computer, le GPU di un data center devono anche comunicare tra loro.

Ciò richiede un’attrezzatura di rete sempre più avanzata, come switch, router e chip specializzati. Secondo la società di ricerca 650 Group, il mercato per tali dispositivi dovrebbe crescere del 40% all’anno nei prossimi anni, raggiungendo quasi 9 miliardi di dollari entro il 2027. Nvidia, che concede anche licenze per tali dispositivi, rappresenta il 78% delle vendite globali. Ma anche concorrenti come Arista Networks, un’azienda californiana, stanno attirando l’attenzione degli investitori: il suo prezzo delle azioni è aumentato di quasi il 70% nell’ultimo anno. Broadcom, che vende chip specializzati che aiutano il funzionamento delle reti, ha dichiarato che le sue vendite annuali di tali semiconduttori quadruplicheranno nel 2023, raggiungendo 800 milioni di dollari.

L’esplosione dell’IA è anche una buona notizia per le aziende che assemblano i server che vanno nei data center, osserva Peter Rutten di IDC, un’altra società di ricerca. Dell’Oro Group, un’altra società di analisti, prevede che i data center di tutto il mondo aumenteranno la quota di server dedicati all’IA dal meno del 10% attuale a circa il 20% entro cinque anni, e che la quota di spesa di capitale dei data center per l’equipaggiamento dei server aumenterà dal circa 20% attuale al 45%.

Ciò beneficerà i produttori di server come Wistron e Inventec, entrambi di Taiwan, che producono server personalizzati principalmente per i grandi provider di cloud come Amazon Web Services (AWS) e Azure di Microsoft. Anche i produttori più piccoli dovrebbero ottenere buoni risultati. I dirigenti di Wiwynn, un altro produttore di server taiwanese, hanno recentemente affermato che i progetti legati all’IA rappresentano più della metà del loro ordine attuale. Super Micro, un’azienda americana, ha dichiarato che nei tre mesi fino ad aprile i prodotti legati all’IA hanno rappresentato il 29% delle sue vendite, in aumento rispetto a una media del 20% nei precedenti 12 mesi.

Tutto questo hardware per l’IA richiede software specializzato per funzionare. Alcuni di questi programmi provengono dalle aziende di hardware; ad esempio, la piattaforma software di Nvidia, chiamata CUDA, consente ai clienti di sfruttare al massimo le sue GPU. Altre aziende creano applicazioni che consentono alle aziende di IA di gestire i dati (Datagen, Pinecone, Scale AI) o ospitare modelli di linguaggio estesi (HuggingFace, Replicate). PitchBook conta circa 80 start-up di questo tipo. Più di 20 hanno raccolto nuovi capitali fino ad ora quest’anno; Pinecone conta Andreessen Horowitz e Tiger Global, due giganti del venture capital, tra gli investitori.

Come per l’hardware, i principali clienti per gran parte di questo software sono i giganti del cloud. Insieme, Amazon, Alphabet e Microsoft prevedono di investire circa 120 miliardi di dollari quest’anno, rispetto ai 78 miliardi di dollari del 2022. Gran parte di questi investimenti sarà destinata all’espansione delle loro capacità di cloud. Tuttavia, la domanda di elaborazione dell’IA è così elevata che persino loro faticano a tenere il passo.

Ciò ha creato un’opportunità per i contendenti. Negli ultimi anni IBM, Nvidia ed Equinix hanno iniziato a offrire l’accesso alle GPU “come servizio”. Le start-up di cloud focalizzate sull’IA stanno proliferando. A marzo, una di esse, Lambda, ha raccolto 44 milioni di dollari da investitori come Gradient Ventures, uno dei bracci di venture di Google, e Greg Brockman, co-fondatore di OpenAI. L’accordo ha valutato l’azienda circa 200 milioni di dollari. Un’azienda simile, CoreWeave, ha raccolto 221 milioni di dollari ad aprile, incluso da Nvidia, con una valutazione di 2 miliardi di dollari. Brannin McBee, co-fondatore di CoreWeave, sostiene che la focalizzazione sul servizio clienti e l’infrastruttura progettata attorno all’IA li aiutino a competere con i giganti del cloud.

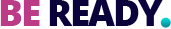

L’ultimo gruppo di vincitori dell’infrastruttura dell’IA sono quelli che forniscono i veri “picconi”: i proprietari dei data center. Con l’aumento della domanda di cloud computing, le loro proprietà si stanno riempiendo. Nel secondo semestre del 2022, i tassi di vacanza dei data center si attestavano al 3%, un minimo storico. Specialisti come Equinix o il suo rivale Digital Realty competono sempre più con grandi gestori di asset, che sono interessati ad aggiungere i data center ai loro portafogli immobiliari. Nel 2021 Blackstone, un gigante dei mercati privati, ha pagato 10 miliardi di dollari per QTS Realty Trust, uno dei più grandi operatori di data center americani. Ad aprile, Brookfield, il rivale canadese di Blackstone che ha investito pesantemente in data center, ha acquistato Data4, un’azienda francese di data center.

La crescita continua dello stack di infrastrutture dell’IA potrebbe tuttavia incontrare dei limiti. Uno di essi è l’energia. Un grande investitore nei data center nota che l’accesso all’elettricità, di cui i data center sono grandi consumatori, si prevede che rallenti lo sviluppo di nuovi data center nei centri come la Virginia settentrionale e la Silicon Valley. Un altro ostacolo potenziale è un passaggio da modelli di IA vasti e inference basate su cloud a sistemi più piccoli che richiedono meno potenza di calcolo per l’addestramento e possono eseguire l’inference su uno smartphone, come nel caso della versione ridotta di PaLM di Google recentemente presentata.

La più grande incognita riguarda la durata stessa del boom dell’IA. Nonostante la popolarità di ChatGPT e compagnia, rimane poco chiaro quali siano i casi d’uso redditizi per questa tecnologia. Nella Silicon Valley, l’entusiasmo può trasformarsi in delusione in un attimo. Il valore di mercato di Nvidia è schizzato verso l’alto nel 2021, poiché le sue GPU si sono rivelate perfette per il mining di bitcoin e altre criptovalute, per poi crollare quando il boom delle criptovalute è andato in rovina.

E se la tecnologia dovesse realmente corrispondere alle sue promesse trasformative, i regolatori potrebbero intervenire. I decisori politici di tutto il mondo, preoccupati per il potenziale dell’IA generativa di eliminare posti di lavoro o diffondere disinformazione, stanno già ponderando l’adozione di misure di controllo. Infatti, l’11 maggio i legislatori dell’UE hanno proposto una serie di regole che limiterebbero l’uso dei chatbot.

Tutti questi fattori limitanti potrebbero rallentare la diffusione dell’IA e, di conseguenza, ridurre le prospettive delle aziende di infrastrutture dell’IA. Tuttavia, probabilmente solo in minima parte. Anche se l’IA generativa non dovesse rivelarsi così trasformativa come affermano i suoi sostenitori, quasi certamente sarà più utile delle criptovalute. E ci sono molte altre forme di IA, non-generative, che richiedono comunque molta potenza di calcolo. Solo un divieto globale dell’IA generativa, che al momento non è all’orizzonte, potrebbe fermare la corsa all’oro. E finché tutti si affrettano, i venditori di picconi e pale continueranno a fare affari.